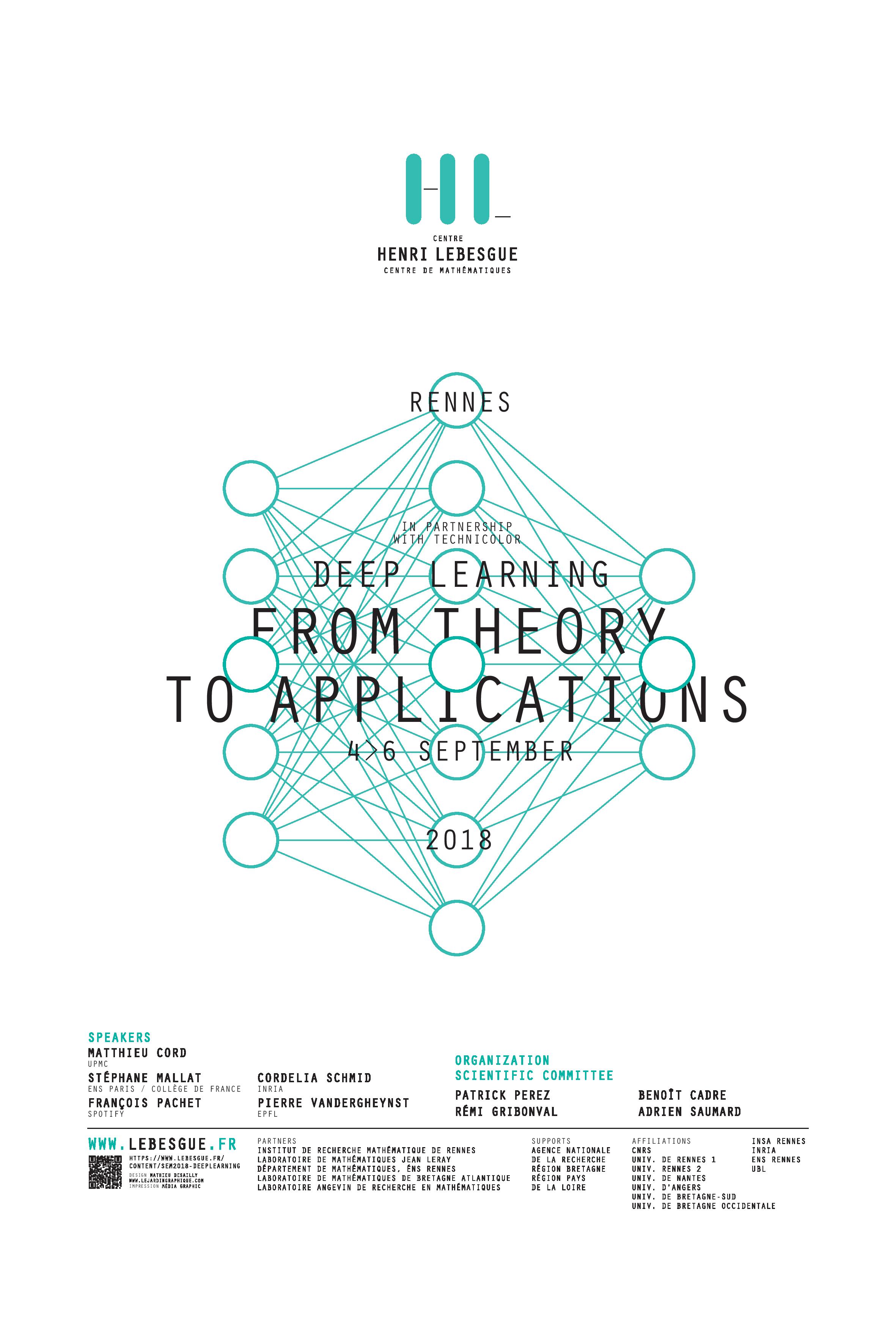

Rennes, du 4 septembre au 6 septembre 2018

Comité d'organisation : Patrick Perez, Rémi Gribonval, Benoît Cadre, Adrien Saumard, Lionel Oisel

Comité scientifique : Lionel Oisel (Technicolor), Patrick Perez (Valeo), Rémi Gribonval (Inria), Benoît Cadre (ENS Rennes), Adrien Saumard (ENSAI)

L’apprentissage profond (deep learning) est à l’origine du renouveau spectaculaire de l’intelligence artificielle (IA). Cette branche ancienne de l’apprentissage machine a connu depuis 2006 dans le domaine du traitement de la parole et depuis 2012 dans celui de la reconnaissance visuelle un regain exceptionnel, autorisant des progrès fulgurants sur des tâches importantes et difficiles. Depuis, un nombre croissant de communautés scientifiques (apprentissage machine, traitement des signaux et des images, reconnaissance du texte, de la parole et de images, vision artificielle, etc.) ont très largement embrassé le deep learning, devenu de facto la source principale de leur développement. Applications, algorithmes, données, librairies logicielles se sont depuis développés à une vitesse considérable, et le plus souvent avec libre accès à tous (code libre en particulier). L’impact est également sociétal et industriel. Les grands groupes de l’internet, des télécommunications, des médias et du divertissement, de l’automobile, des biotechnologies et de la pharmacie, de la banque, etc. investissent désormais de façon massive dans ces technologies et leurs développements, que ce soit en R&D, en recherche amont ou en collaborations avec les meilleures universités du monde.

Derrière cette révolution en marche se cache un ensemble de modèles mathématiques et d’algorithmes associés qui sont à la fois relativement simples dans leur conception et très complexes à mettre en œuvre et à analyser. Les réseaux de neurones artificiels et leur apprentissage par gradient stochastique se sont pour l’heure développés de façon empirique. Les meilleures architectures et leur dimensionnement, les fonctions de perte à optimiser, les nombreux « trucs et astuces » requis pour mener à bien un apprentissage (différents types de régularisation, supervision et augmentation des données, vitesse d’apprentissage et autres paramètres du solveur randomisé) ont pour l’essentiel vu le jour de façon expérimentale. En parallèle du développement continu de ses techniques et savoir-faire, le besoin d’une meilleure compréhension mathématique de ces outils incroyablement performants se fait de plus en plus sentir. Pour consolider et améliorer encore les performances des systèmes existants, pour en comprendre théoriquement les limites, et pour préparer les prochaines évolutions et ruptures du domaine.

En réunissant autour d’exposés scientifiques exigeants et variés des mathématiciens, des experts du deep learning et des praticiens venus d’horizons très divers, le workshop que nous proposons ambitionne d’abord de contribuer à cette synergie nécessaire entre mathématiques appliquées et apprentissage profond. Il vise également à mieux faire connaître les outils du deep learning à des communautés scientifiques et industrielles qui n’ont en pas encore pleinement tiré parti.